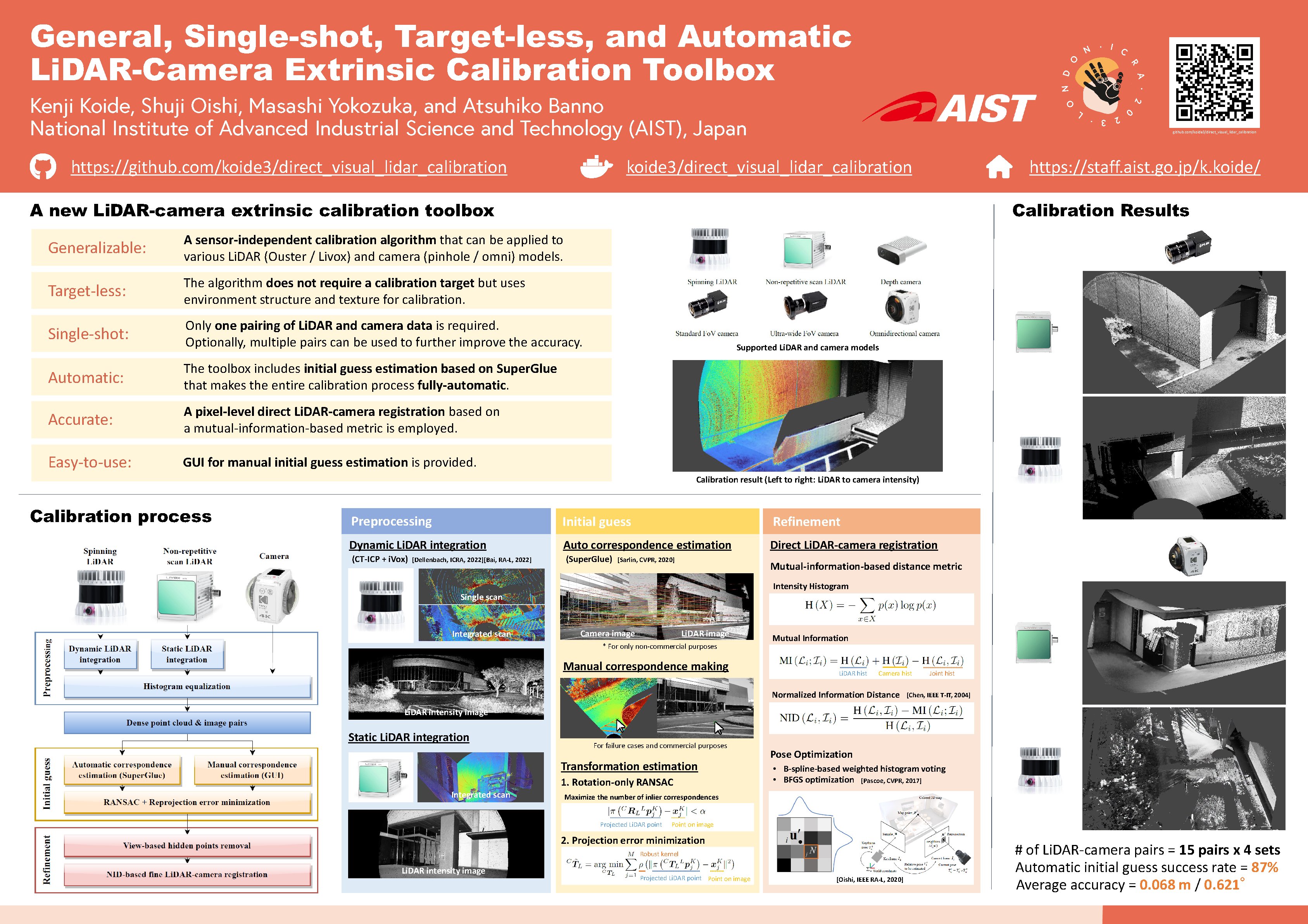

LiDAR・カメラ 外部パラメータキャリブレーション

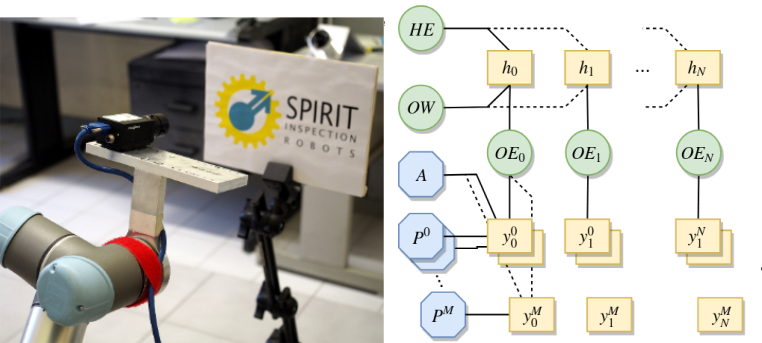

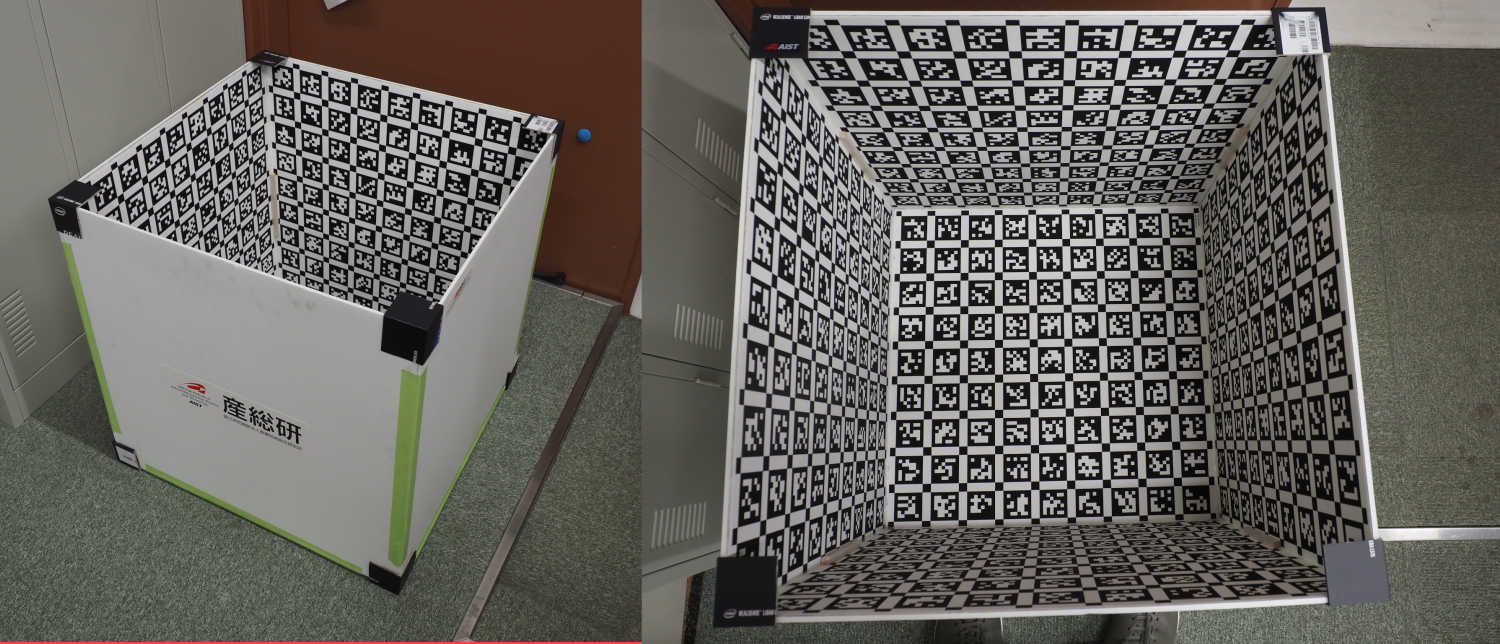

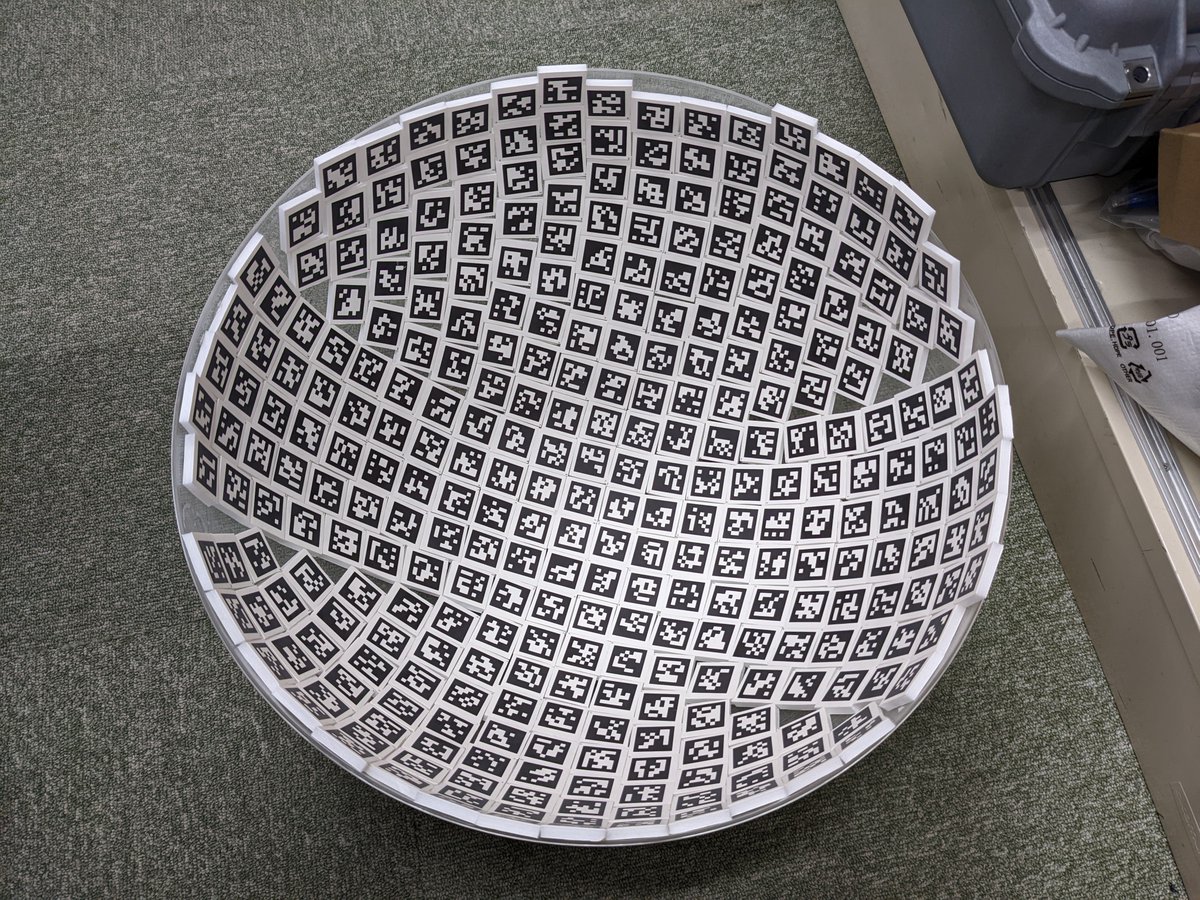

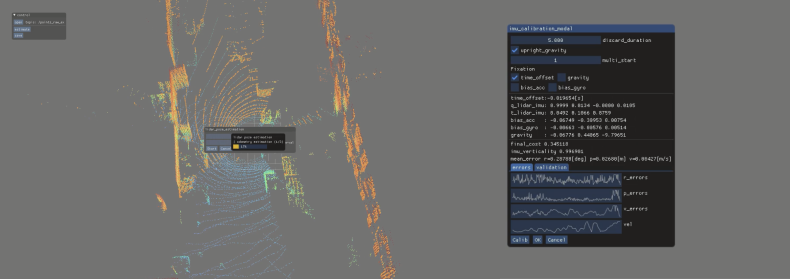

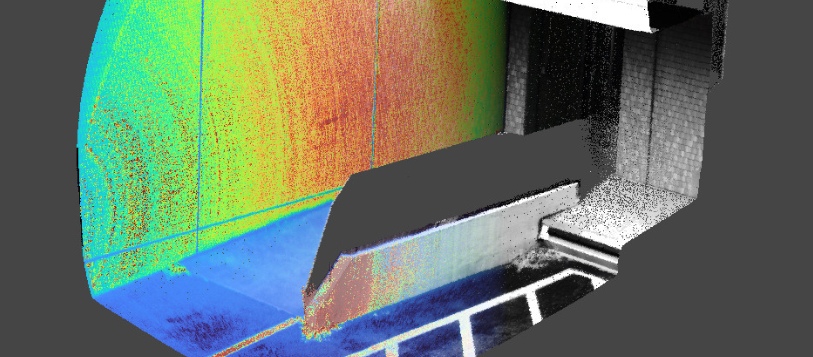

LiDAR・カメラ間の相対姿勢を求めることは応用上重要である一方,既存手法は特殊なキャリブレーションターゲットや多数のデータ計測が必要であったり,特定の種類のLiDARにしか使えないなどの問題があります. この研究では,2D-3D対応付による自動初期値推定とNIDによる点群・画像アラインメントを組み合わせることで,任意の点群センサに使用でき,キャリブレーションターゲットを必要とせず,自動でキャリブレーションを行えるフレームワークを提案しました.

関連論文

General, Single-shot, Target-less, and Automatic LiDAR-Camera Extrinsic Calibration Toolbox, ICRA2023